著名な国際的専門家グループが先週北京で会合を開き、生物兵器の開発やサイバー攻撃の実行など、AI開発における「越えてはならない一線」を特定した。

会議の数日後に出された声明の中で、学者らは「我々の生きている間に人類に壊滅的な、あるいは存在そのものを脅かすようなリスク」を防ぐためには、AIの安全性に対する共通のアプローチが必要だと警告した。

「冷戦の真っ只中、国際的な科学技術協力と政府協力は核による大惨事の防止に貢献した。人類は再び、前例のない技術から生じ得る大惨事を防ぐために協力しなければならない」と声明は述べた。

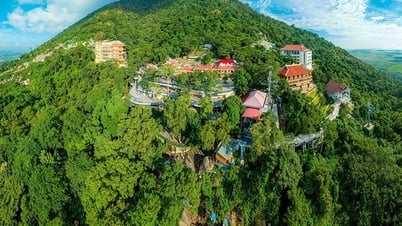

北京で開催されたAI安全に関する国際対話の専門家らは、AI開発における「越えてはならない一線」を特定した。写真:FT

署名者には、AIの「父」と呼ばれることが多いジェフリー・ヒントン氏とヨシュア・ベンジオ氏が含まれています。カリフォルニア大学のコンピュータサイエンス教授、スチュアート・ラッセル氏そして、中国で最も著名なコンピューター科学者の一人であるアンドリュー・ヤオ氏。

この声明は、先週北京で開かれた国際AI安全対話の後に出されたもので、中国政府関係者らが出席し、フォーラムとその成果に対する承認を表明した。

ジョー・バイデン米大統領と中国の習近平国家主席は昨年11月に会談し、AIの安全性について話し合い、この問題について対話を始めることで合意した。ここ数カ月、世界の大手AI企業も中国のAI専門家と非公式に会合を重ねている。

2023年11月、英国リシ・スナック財務大臣のAI安全サミットにおいて、中国を含む28か国と主要なAI企業が、高度なAIに起因する実存的リスクに対処するために協力するという幅広い約束に合意した。

先週北京で専門家らが「汎用人工知能(AGI)」、つまり人間と同等かそれ以上のAIシステムの開発に伴う脅威について議論した。

「議論の中心は、強力なAIシステムが越えてはならない一線、そして世界中の政府がAIの開発と展開において課すべき一線だった」とベンジオ氏は述べた。

これらのレッドラインにより、「いかなる AI システムも、明示的な人間の同意とサポートなしに自己複製または自己改善することはできない」、あるいは「その力と影響力を不当に高める行動をとることはできない」ことが保証される。

科学者らは、いかなるシステムも「大量破壊兵器を設計する能力、生物兵器や化学兵器禁止条約に違反する能力を著しく高める」ことはなく、「深刻な経済的損失や同等の損害をもたらすサイバー攻撃を自動的に実行する」こともできないだろうと付け加えた。

ホアンハイ(FTによると)

[広告2]

ソース

![[写真] ルオン・クオン大統領が歓迎式典を主宰し、スリランカのアヌラ・クマラ・ディサナヤカ大統領と会談した。](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/5/bbb34e48c0194f2e81f59748df3f21c7)

![[写真] 国会議員代表団がホーチミン主席廟を訪問](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/5/9c1b8b0a0c264b84a43b60d30df48f75)

コメント (0)