In einer Erklärung betonten Branchenführer und Experten, dass die Bewältigung der Risiken durch KI „neben anderen Risiken wie Pandemien und Atomkrieg“ eine „globale Priorität“ sein müsse, so AFP. Die Erklärung wurde von Dutzenden Experten unterzeichnet, darunter Sam Altman, CEO von OpenAI, dem Unternehmen, das die ChatGPT-Plattform entwickelt hat.

ChatGPT erlangte Ende letzten Jahres Berühmtheit durch seine Fähigkeit, aus kürzesten Eingabeaufforderungen Essays, Gedichte und Chats zu generieren. Der ChatGPT-Hype hat Milliarden von Dollar an Investitionen im KI-Bereich angezogen.

ChatGPT-Logo und das englische Wort „Artificial Intelligence“ (AI)

Branchenexperten schlagen jedoch Alarm, da es viele Gefahren gibt, von voreingenommenen KI-Algorithmen bis hin zum Risiko eines Massenverlusts von Arbeitsplätzen, da die KI-gestützte Automatisierung in den Alltag der Menschen eindringt.

Die jüngste Erklärung, die auf der Website des Center for AI Safety (einer gemeinnützigen Organisation mit Sitz in den USA) veröffentlicht wurde, enthält keine Einzelheiten zu der potenziellen existenziellen Bedrohung durch KI.

Einige der Unterzeichner, darunter auch Geoffrey Hinton, der einige der grundlegenden Technologien für KI-Systeme entwickelt hat und als Vater der Branche gilt, haben in der Vergangenheit bereits ähnliche Warnungen ausgesprochen.

Ihre größte Sorge gilt der Idee der sogenannten künstlichen allgemeinen Intelligenz (AGI). Dabei handelt es sich um ein Konzept, das den Punkt beschreibt, an dem Maschinen in der Lage sind, viele der gleichen Funktionen wie Menschen auszuführen und eigene Programme zu entwickeln.

Das Beunruhigende ist, dass der Mensch nicht länger in der Lage sein wird, KI zu kontrollieren. Experten warnen, dass diese Situation verheerende Folgen für die Menschheit haben könnte.

Dutzende Experten von Unternehmen wie Google und Microsoft unterzeichneten die Erklärung, die laut AFP zwei Monate nach der Forderung des Milliardärs Elon Musk und anderer erfolgte, die Entwicklung von KI-Technologien zu unterbrechen, bis deren Sicherheit bewiesen sei.

[Anzeige_2]

Quellenlink

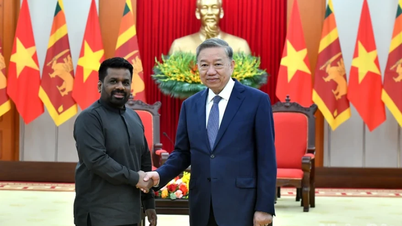

![[Foto] Generalsekretär To Lam empfängt den sri-lankischen Präsidenten Anura Kumara Dissanayaka](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/4/75feee4ea0c14825819a8b7ad25518d8)

![[Foto] Vietnam glänzt auf der Pariser Internationalen Messe 2025 mit kulturellen und kulinarischen Farben](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/4/74b16c2a197a42eb97597414009d4eb8)

![[Foto] Der Busbahnhof füllt sich langsam, da er die Menschen willkommen heißt, die nach fünf Tagen Urlaub in die Hauptstadt zurückkehren](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/4/c3b37b336a0a450a983a0b09188c2fe6)

![[Video]. Entwicklung von OCOP-Produkten auf Basis lokaler Stärken](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/5/3/61677e8b3a364110b271e7b15ed91b3f)

Kommentar (0)