H200と呼ばれるこの新しいチップは、Nvidiaの現在の最上位チップであるH100を上回るものとなる。新しいチップの主なアップグレードは、より高帯域幅のメモリです。これはチップの中で最も高価な部品の 1 つであり、データ処理速度を決定します。

NvidiaのH200チップは、より大規模な人工知能システムに対応します

Nvidiaは現在AIチップ市場を独占しており、OpenAIのChatGPTサービスや人間のような応答を生成する多くのAIサービスにチップを供給している。ロイター通信によると、チップの演算処理要素に高帯域幅メモリと高速接続を追加することで、ChatGPT のようなサービスはより迅速に応答できるようになるという。

H200 には、以前の H100 チップの 80 GB から増加した 141 ギガバイト (GB) の高帯域幅メモリが搭載されています。エヌビディアは新チップのメモリ供給元を明らかにしていないが、マイクロン・テクノロジーは9月にエヌビディアの供給元になるために取り組んでいると発表していた。

Nvidiaはさらに、CoreWeave、Lambda、Vultrなどの専門的なAIクラウドサービスプロバイダーに加えて、Amazon Web Services、Google Cloud、Microsoft Azure、Oracle Cloud InfrastructureがH200チップを活用する最初のクラウドサービスプロバイダーになることを明らかにした。

マイクロソフトがAIチップを発表

[広告2]

ソースリンク

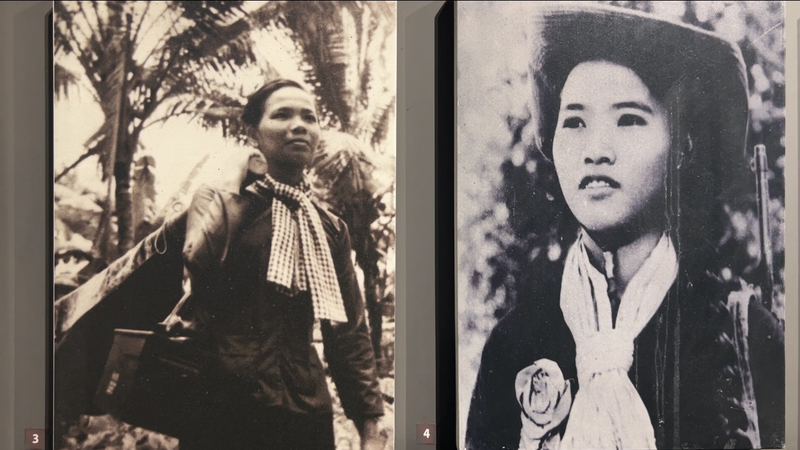

![[写真] 南北解放・祖国統一50周年記念パレードのパノラマ](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/4/30/affbd72e439d4362962babbf222ffb8b)

![[写真] 祖国統一50周年を祝う大規模パレード](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/4/30/825e459ee2f54d85b3a134cdcda46e0d)

コメント (0)