ล่าสุด กรมรักษาความปลอดภัยสารสนเทศ ได้ออกคำเตือนถึงเหตุการณ์ฉ้อโกง ทางวิดีโอ และรูปภาพด้วยเทคโนโลยีขั้นสูงที่เกิดขึ้นอย่างต่อเนื่อง

ด้วยเหตุนี้ สถานการณ์ของผู้ก่ออาชญากรรมทางไซเบอร์ที่ใช้ประโยชน์จากภาพและวิดีโอสาธารณะของบุคคลอื่น เพื่อตัดต่อ ตัดต่อ และข่มขู่แบล็กเมล์ด้วยวิดีโอปลอม จึงได้รับการเตือนจากทางการให้ประชาชนทราบเป็นวงกว้างแล้ว

โดยใช้เทคโนโลยี Deepfake ที่สามารถจำลองเสียงและภาพของบุคคลได้อย่างแม่นยำ อาชญากรสามารถปลอมตัวเป็นผู้นำในการประชุมออนไลน์ หรือสร้างวิดีโอและการโทรเพื่อกระทำการฉ้อโกงทางการเงินได้

นอกจากนี้ การหลอกลวงเหล่านี้มักจะใช้ประโยชน์จากปัจจัยทางจิตวิทยา เช่น ความเร่งด่วน ความกลัว หรืออำนาจ ทำให้เหยื่อดำเนินการอย่างเร่งรีบโดยไม่ตรวจสอบความถูกต้องอย่างรอบคอบ

Deepfakes ไม่ได้จำกัดอยู่แค่การหลอกลวงทางการเงินและการลงทุนเท่านั้น อีกตัวอย่างหนึ่งคือ Romance Scam ซึ่งใช้ Deepfakes เพื่อสร้างตัวละครสมมติที่โต้ตอบกับเหยื่อผ่านวิดีโอคอล หลังจากได้รับความไว้วางใจจากเหยื่อแล้ว ผู้หลอกลวงจะขอโอนเงินเพื่อแก้ปัญหาฉุกเฉิน ค่าเดินทาง หรือเงินกู้

จากสถานการณ์ดังกล่าว กรมรักษาความปลอดภัยข้อมูลจึงแนะนำให้ประชาชนระวังคำแนะนำการลงทุนจากผู้มีชื่อเสียงบนโซเชียลเน็ตเวิร์ก ระวังข้อความ อีเมล หรือการโทรที่ไม่ระบุตัวตน และสังเกตการแสดงออกทางสีหน้าที่ไม่เป็นธรรมชาติในวิดีโออย่างระมัดระวัง

นอกจากนี้ ผู้คนยังต้องจำกัดการโพสต์เนื้อหาที่เกี่ยวข้องกับข้อมูลส่วนบุคคลบนเครือข่ายโซเชียล เพื่อหลีกเลี่ยงการถูกขโมยข้อมูล เช่น รูปภาพ วิดีโอ หรือเสียงโดยผู้ไม่หวังดี ขณะเดียวกัน ควรตั้งค่าบัญชีเป็นโหมดส่วนตัวเพื่อปกป้องข้อมูลส่วนบุคคล

โง มินห์ เฮียว ผู้เชี่ยวชาญด้านความปลอดภัยไซเบอร์และผู้ร่วมก่อตั้งโครงการป้องกันการฉ้อโกงไซเบอร์เวียดนาม (Chongluadao.vn) ให้สัมภาษณ์กับผู้สื่อข่าวหนังสือพิมพ์ได่ ด๋าน เก็ท ว่า การใช้เทคโนโลยีดีปเฟคใน AI เพื่อปลอมวิดีโอคอลเพื่อวัตถุประสงค์ในการฉ้อโกงยังคงมีความซับซ้อน บุคคลเหล่านี้ใช้ประโยชน์จากเทคโนโลยีนี้เพื่อเพิ่มความน่าเชื่อถือให้กับ "เหยื่อ" ของพวกเขา

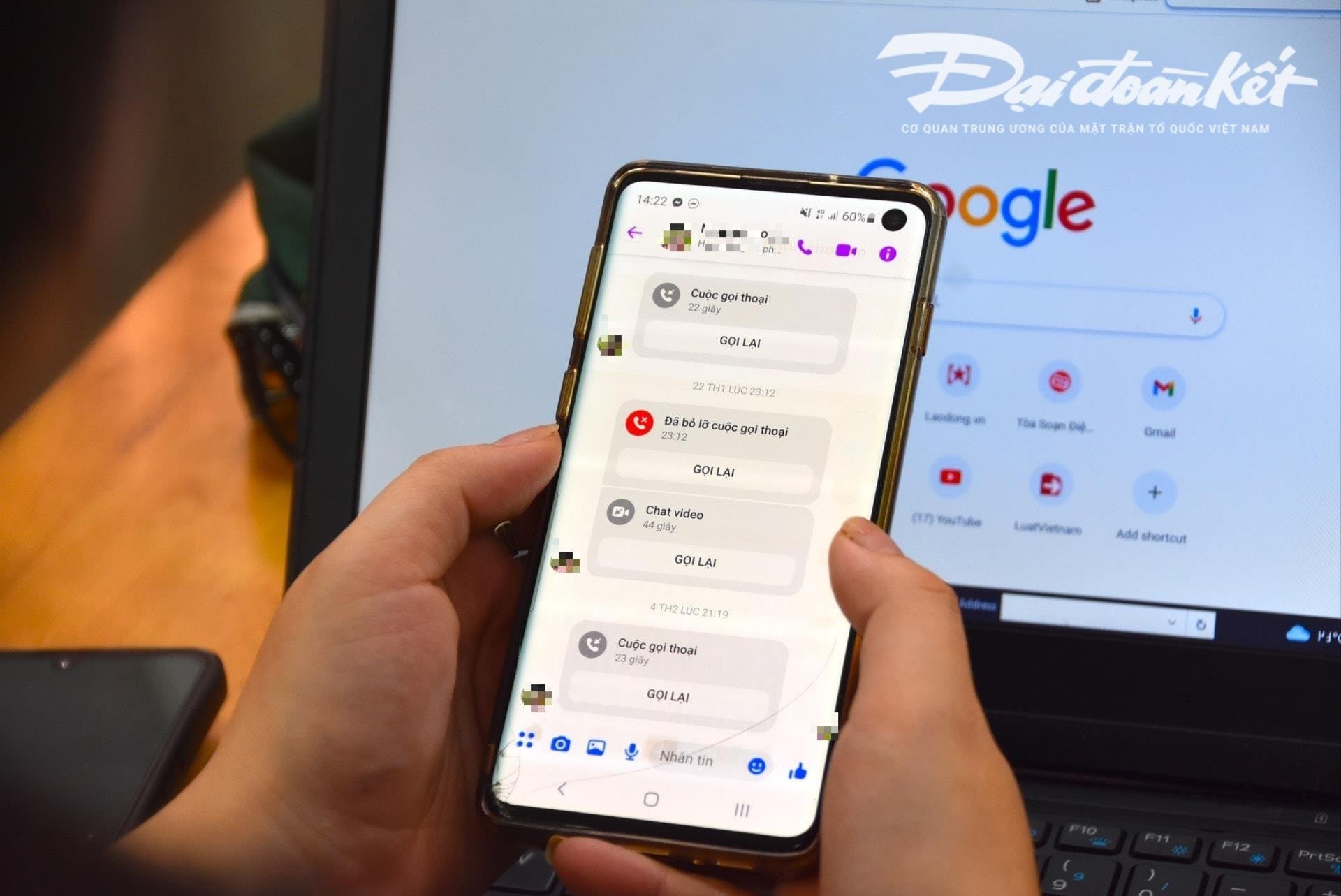

โดยเฉพาะอย่างยิ่ง ผู้ถูกโจมตีจะโทรวิดีโอหาเหยื่อจากรูปภาพและวิดีโอที่ "ถูกขโมย" มาก่อน และประมวลผลทางเทคนิค บิดเบือนเสียง หรือสร้างปัญหาภาพปลอมเพื่อให้เหยื่อไว้วางใจ

โดยปกติแล้ว การโทรเหล่านี้มักจะสั้นมาก ใช้เวลาเพียงไม่กี่วินาที จากนั้นผู้หลอกลวงจะใช้ข้ออ้างว่าเครือข่ายไม่เสถียร อยู่บนถนน ฯลฯ เพื่อขอให้เหยื่อทำตามคำขอของผู้หลอกลวง

ผู้เชี่ยวชาญเตือนว่าการใช้ AI เพื่อการฉ้อโกงทางไซเบอร์มีแนวโน้มที่จะเพิ่มขึ้นอย่างมากในอนาคตอันใกล้ ดังนั้น ผู้คนจึงต้องสร้างความตระหนักรู้เชิงรุก โดยเฉพาะอย่างยิ่งเมื่อได้รับข้อความ วิดีโอคอล และลิงก์แปลก ๆ

ตามการวิเคราะห์ของผู้เชี่ยวชาญ อัลกอริทึมปัญญาประดิษฐ์ (AI) ของ Deepfake ในปัจจุบันจะไม่สามารถจัดการได้หากผู้โทรเลี้ยวซ้าย เลี้ยวขวา หรือยืนขึ้นในระหว่างการโทรแบบเรียลไทม์...

จุดอ่อนอย่างหนึ่งที่ผู้คนต้องใส่ใจเมื่อรับสายเหล่านี้คือฟัน ดังนั้น อัลกอริทึม AI ในปัจจุบันจึงไม่สามารถจำลองฟันของบุคคลที่ถูกปลอมแปลงได้

หากใช้ Deepfake ภาพของคนที่อ้าปากอาจไม่มีฟัน บางคนมีขากรรไกร 3 ขากรรไกร หรือแม้กระทั่ง 4 ขากรรไกร ดังนั้น ลักษณะของฟันจึงเป็นองค์ประกอบที่จดจำได้ง่ายที่สุดของการโทรปลอมโดยใช้ Deepfake

การ “ชะลอความเร็ว” และไม่ปฏิบัติตามคำขอทันทีเป็นสิ่งจำเป็นเพื่อหลีกเลี่ยงการตกหลุมพรางของการหลอกลวง เมื่อได้รับข้อความหรือโทรศัพท์ผ่านโซเชียลมีเดีย บุคคลควรโทรหาญาติโดยตรงเพื่อยืนยันตัวตนว่าใครเป็นผู้ติดต่อกับพวกเขา โดยใช้เวลาอย่างน้อย 30 วินาที หรือพบปะกันโดยตรง

ในกรณีที่สงสัยว่ามีการแอบอ้างเป็นญาติในโซเชียลเน็ตเวิร์กเพื่อฉ้อโกงหรือยักยอกทรัพย์สิน จำเป็นต้องรายงานไปยังหน่วยงานตำรวจที่ใกล้ที่สุดทันที เพื่อการสนับสนุนและการจัดการอย่างทันท่วงที

ที่มา: https://daidoanket.vn/chuyen-gia-chi-meo-nhan-biet-cuoc-goi-deepfake-lua-dao-10300910.html

![[ภาพ] นายกรัฐมนตรี Pham Minh Chinh เป็นประธานการประชุมคณะกรรมการประจำพรรครัฐบาล](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/8/23/8e94aa3d26424d1ab1528c3e4bbacc45)

![[ภาพ] เลขาธิการโต ลัม เข้าร่วมงานฉลองครบรอบ 80 ปี วันประเพณีภาควัฒนธรรม](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/8/23/7a88e6b58502490aa153adf8f0eec2b2)

การแสดงความคิดเห็น (0)