(CLO) OpenAI의 음성-텍스트 변환 도구인 Whisper는 "인간 수준에 가까운 강력하고 정확하다"고 광고되지만, 하나의 큰 단점이 있습니다. 텍스트 조각이나 심지어 전체 문장을 조작할 가능성이 있다는 것입니다!

전문가들은 환각제라고 불리는 일부 텍스트에는 인종적 논평, 폭력, 심지어 상상 속의 의학적 치료법까지 포함될 수 있다고 말합니다.

전문가들은 Whisper가 전 세계 다양한 산업에서 인터뷰를 번역하고 필사하고, 텍스트를 생성하고 영상에 자막을 넣는 데 사용되기 때문에 이러한 조작이 심각하다고 말합니다.

더욱 우려스러운 점은 OpenAI가 "고위험 지역"에서는 이 도구를 사용해서는 안 된다고 경고했음에도 불구하고, 의료 센터에서는 환자와 의사의 상담을 기록하기 위해 Whisper 기반 도구를 사용하고 있다는 것입니다.

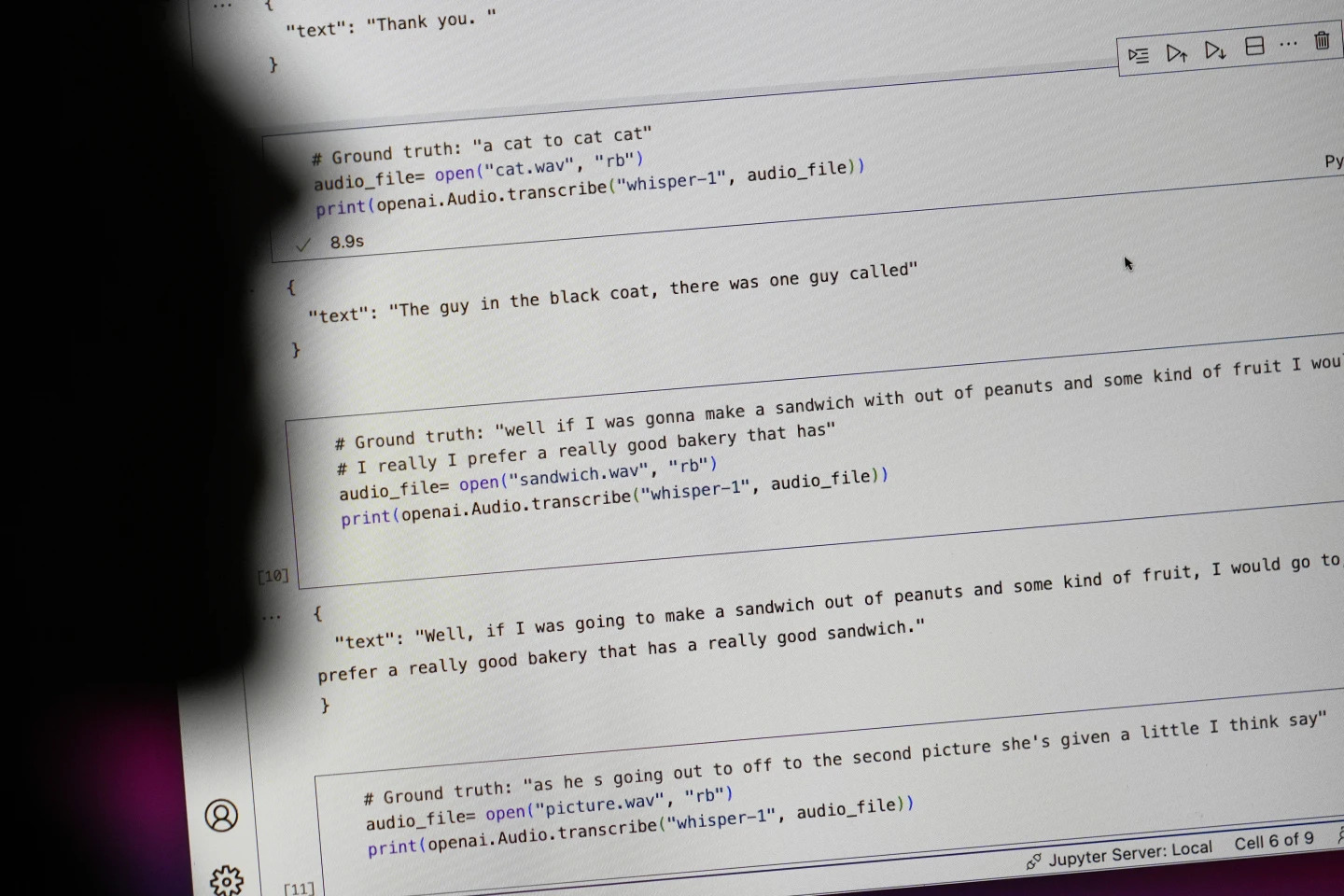

"#Ground truth"로 시작하는 문장은 실제로 말한 내용이고, "#text"로 시작하는 문장은 Whisper가 필사한 내용입니다. 사진: AP

연구자들과 엔지니어들은 위스퍼를 사용하는 동안 종종 환각 현상이 나타난다고 말한다. 예를 들어, 미시간 대학의 한 연구원은 자신이 조사한 녹음 파일 10개 중 8개에서 환각 현상을 발견했다고 말했습니다.

머신 러닝 엔지니어는 자신이 분석한 100시간 이상의 위스퍼 대화 내용 중 약 절반에서 처음에 왜곡을 발견했습니다. 세 번째 개발자는 Whisper를 사용해 작성된 26,000개의 메모 중 거의 대부분에서 환각을 감지했다고 말했습니다.

이런 환상은 잘 녹음된 짧은 오디오 샘플에서도 지속됩니다. 컴퓨터 과학자들이 실시한 최근 연구에 따르면, 13,000개 이상의 선명한 오디오 클립에서 187개의 왜곡이 발견되었습니다.

연구자들은 그러한 추세로 인해 수백만 건의 녹음에서 수만 건의 오류가 발생할 것이라고 말했습니다.

고등연구소 사회과학대학의 알론드라 넬슨 교수는 이러한 실수는 특히 병원 환경에서 "정말 심각한 결과"를 초래할 수 있다고 말했습니다.

"아무도 오진을 받고 싶어 하지 않습니다. 더 높은 장벽이 필요합니다."라고 넬슨은 말했습니다.

코넬 대학의 앨리슨 코에네케 교수와 버지니아 대학의 모나 슬론 교수는 카네기 멜론 대학에 있는 연구 기록 보관소인 TalkBank에서 검색한 수천 개의 짧은 발췌문을 조사했습니다. 그들은 환각의 약 40%가 말하는 사람의 말이 오해되거나 잘못 전달될 수 있기 때문에 해롭거나 불쾌감을 준다는 것을 알아냈습니다.

한 녹음에서 한 화자는 "다른 두 소녀와 한 여성"을 묘사했지만, 위스퍼는 "다른 두 소녀와 한 여성, 음, 흑인"이라는 추가적인 인종적 언급을 날조했습니다.

또 다른 기록에 따르면, 위스퍼는 "활성이 증가된 항생제"라는 존재하지 않는 약을 발명했습니다.

대부분의 개발자는 필사 도구가 철자 오류나 기타 오류를 범할 수 있다고 생각하지만, 엔지니어와 연구자들은 Whisper만큼 환각적인 AI 기반 필사 도구를 본 적이 없다고 말합니다.

이 도구는 OpenAI의 주력 챗봇인 ChatGPT의 여러 버전에 통합되어 있으며, Oracle과 Microsoft의 클라우드 컴퓨팅 플랫폼에 통합된 서비스로 전 세계 수천 개 기업에 서비스를 제공하고 있습니다. 또한 텍스트를 여러 언어로 번역하고 필사하는 데에도 사용됩니다.

응옥 안 (AP에 따르면)

[광고_2]

출처: https://www.congluan.vn/cong-cu-chuyen-giong-noi-thanh-van-ban-ai-cung-co-the-xuyen-tac-post319008.html

![[사진] 루옹 꾸엉 대통령이 환영식을 주재하고 스리랑카 대통령 아누라 쿠마라 디사나야카와 회담을 가졌습니다.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/5/bbb34e48c0194f2e81f59748df3f21c7)

![[사진] 제15대 국회 제9기 정기 개원](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/5/ad3b9de4debc46efb4a0e04db0295ad8)

![[사진] 국회 대의원들, 호찌민 주석 묘소 참배](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/5/9c1b8b0a0c264b84a43b60d30df48f75)

댓글 (0)