1월 말, DeepSeek은 미국 제품과 동급이면서도 가격은 훨씬 저렴한 두 개의 LLM 모델을 출시하며 글로벌 기술계에 돌풍을 일으켰습니다. 그 중 오픈소스 추론 모델인 DeepSeek-R1은 OpenAI의 가장 진보된 LLM인 o1과 동일한 과학적 문제 중 일부를 해결할 수 있습니다.

세계가 놀란 가운데, 국내 연구진은 이 성과는 완전히 예측 가능한 것이었으며 인공 지능(AI) 분야에서 선도적인 강국이 되려는 베이징의 야망에 부합한다고 말했습니다.

중국과학원 컴퓨터과학연구소의 컴퓨터 과학자인 천윤지(陈雲智)는 DeepSeek과 같은 회사가 조만간 중국에 등장할 것이라고 지적합니다.

이는 LLM 개발 기업에 막대한 투자 자본이 쏟아지고 STEM(과학, 기술, 공학 또는 수학) 분야에서 박사 학위를 취득한 사람이 많아졌기 때문입니다.

"DeepSeek가 없었다면 다른 중국 LLM이 있었을 겁니다."라고 천 씨는 말했습니다.

이는 입증된 사실입니다. DeepSeek "지진"이 발생한 지 며칠 후, Alibaba는 지금까지 가장 발전된 LLM인 Qwen2.5-Max를 출시했습니다. 이는 DeepSeek-V3보다 성능이 뛰어나다고 회사 측은 주장합니다.

Moonshot AI와 ByteDance도 새로운 추론 모델인 Kimi 1.5와 1.5-pro를 발표했는데, 이는 일부 벤치마크 테스트에서 o1보다 우수한 성능을 보였습니다.

정부의 우선순위

2017년 중국 정부는 2030년까지 AI 분야에서 세계적인 선두주자가 되겠다는 포부를 발표했습니다. 중국은 2025년까지 AI 분야에서 획기적인 발전을 이루어 "기술과 응용 분야가 세계 최고 수준에 도달"하는 것을 목표로 합니다.

그러기 위해서는 AI 인재 시스템 개발이 최우선 과제입니다. 조지타운 대학교 보안 및 신흥기술 센터(CSET)의 보고서에 따르면, 중국 교육부는 2022년까지 440개 대학에서 AI 전공을 제공하도록 허용할 예정입니다.

컨설팅 회사인 MacroPolo에 따르면, 같은 해 중국은 상위 AI 연구자 수의 절반을 차지한 반면, 미국은 단 18%만 기여했습니다.

시드니 공과대학교의 정책 과학 연구원인 마리나 장은 DeepSeek이 수많은 장학금, 연구 보조금, 학계와 산업 간의 파트너십을 포함하여 AI 교육 및 인재 개발에 대한 정부 투자의 혜택을 받았을 가능성이 크다고 말했습니다.

예를 들어, 국립 딥러닝 기술 및 응용 공학 연구소와 같은 국가 지원 이니셔티브를 통해 수천 명의 AI 전문가가 양성되었습니다.

DeepSeek의 직원에 대한 정확한 수치를 찾기는 어렵지만, 창립자인 량원펑은 회사가 중국 최대 규모의 대학에서 대학원생과 박사과정 학생을 모집한다고 밝혔습니다.

장은 리더십 팀 구성원 중 일부는 35세 미만이며 중국이 기술 초강대국으로 부상하는 것과 함께 성장했다고 말했습니다. "그들은 혁신에 대한 자립심에 큰 동기를 부여받습니다."

39세의 웬펑은 저장대학교에서 컴퓨터 과학 학위를 취득했습니다. 그는 약 10년 전에 헤지펀드 High-Flyer를 공동 창립했고, 2023년에 DeepSeek을 창립했습니다.

CSET에서 중국의 AI 인재를 연구하는 제이콥 펠드고이즈에 따르면, AI를 위한 모델 생태계를 육성하는 국가 정책은 DeepSeek과 같은 회사가 자금과 인력을 모두 유치하는 데 도움이 될 것입니다.

하지만 대학에서 AI 과목이 늘어나고 있음에도 불구하고 펠드고이즈는 AI 학위를 취득한 학생이 몇 명인지, 그리고 이들이 기업에 필요한 기술을 배우고 있는지 확신하지 못하고 있습니다.

최근 몇 년 동안 중국의 AI 기업들은 이런 프로그램을 졸업한 인재들이 기대에 부응하지 못한다고 불평해 왔고, 이로 인해 일부 기업은 품질 개선을 위해 대학과 협력하게 되었습니다.

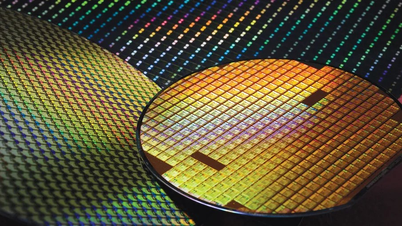

"템퍼링"

과학자들은 DeepSeek의 성공에서 가장 인상적인 요소는 2022년 이래 첨단 AI 컴퓨팅 칩에 대한 접근을 차단한 미국 정부의 수출 통제 상황에서 DeepSeek-R1과 Janus-Pro-7B를 개발했다는 점이라고 말합니다.

장 씨에 따르면, DeepSeek은 혁신에 대한 중국식 접근 방식을 대표하며, 많은 제약에도 불구하고 효율성을 강조합니다.

웬펑의 스타트업은 DeepSeek-V3를 훈련하는 데 약 2,000개의 Nvidia H800 칩을 사용했다고 밝혔습니다. 이와 대조적으로, Meta가 2024년 7월에 출시한 정교한 LLM인 Llama 3.1 405B는 16,000개가 넘는 Nvidia H100 칩을 기반으로 합니다.

2022년 WeChat 게시물에서 High-Flyer는 Nvidia의 구형 A100 칩을 10,000개 보유하고 있다고 밝혔습니다. 웬펑은 2024년 7월 중국 언론과의 인터뷰에서 "우리가 직면한 문제는 결코 돈 문제가 아니라, 고가 칩 금지입니다."라고 말했습니다.

DeepSeek은 다양한 방법을 사용하여 모델의 효율성을 높입니다. 예를 들어, 이 기술은 기존 기술보다 더 적은 매개변수로 더 빠르게 모델을 학습시키는 머신 러닝 접근 방식인 MoE(전문가 혼합) 아키텍처를 구현합니다.

시드니 대학의 컴퓨터 과학자 창 쉬에 따르면, 이는 DeepSeek이 더 적은 칩으로 모델을 훈련하는 데 도움이 된다고 합니다.

또 다른 기술은 멀티헤드 잠재 주의(MLA)로, 모델이 더 적은 메모리로 더 많은 데이터를 저장할 수 있게 해줍니다.

홍콩대학교의 정책과학 연구원인 얀보 왕은 DeepSeek의 성과가 AI에 대한 야망을 가지고 있지만 대규모 LLM을 양성할 재정 및 하드웨어 자원이 부족한 국가에 "지침"이 될 수 있다고 말했습니다.

(자연과 운명에 따르면)

출처: https://vietnamnet.vn/cach-trung-quoc-tao-ra-deepseek-va-rung-chuyen-the-gioi-2391114.html

![[사진] 퍼레이드는 수만 명의 사람들의 품에 안겨 거리로 나갔습니다.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/4/30/180ec64521094c87bdb5a983ff1a30a4)

![[사진] 남방해방 50주년 및 조국통일의 날 문화·스포츠·미디어 블록](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/4/30/8a22f876e8d24890be2ae3d88c9b201c)

![[사진] 중국·라오스·캄보디아군, 남한 해방 50주년 및 조국통일 기념 퍼레이드 참가](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/4/30/30d2204b414549cfb5dc784544a72dee)

댓글 (0)