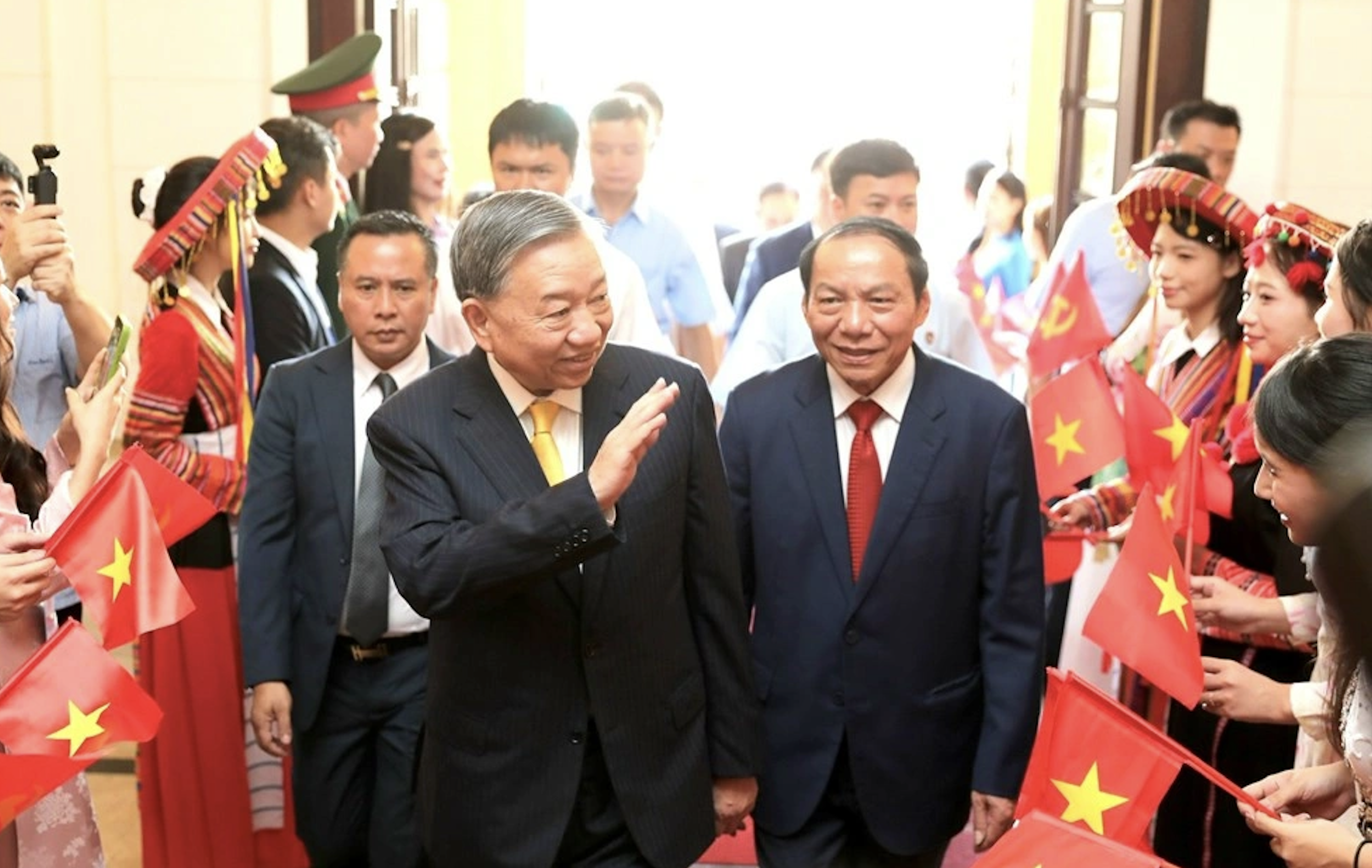

Laut Android Authority beschreibt Apples Forschungsbericht eine Lösung für die Ausführung großer Sprachmodelle (LLMs) auf Geräten mit begrenztem RAM. Der Bericht zeigt, wie das Unternehmen „Modellparameter“ speichern und bei Bedarf einen Teil davon in den RAM des Geräts laden kann, anstatt das gesamte Modell in den RAM zu laden.

Apple möchte älteren iPhones mit weniger RAM helfen, allgemeine KI auszuführen

In dem Dokument wird behauptet, dass diese Methode die Ausführung von Modellen ermöglicht, die den doppelten RAM eines iPhones benötigen, und dabei immer noch eine 4- bis 5-fache bzw. 20- bis 25-fache Inferenzgeschwindigkeit im Vergleich zu einfachen Lademethoden auf der CPU bzw. GPU gewährleistet.

Der Einsatz synthetischer KI auf einem Gerät mit mehr RAM wäre ein großer Vorteil, da er schnellere Lese-/Schreibgeschwindigkeiten ermöglichen würde. Geschwindigkeit ist für On-Device-KI wichtig, da sie deutlich schnellere Inferenzzeiten ermöglicht, da Nutzer nicht unbedingt Dutzende von Sekunden (oder länger) auf eine Antwort oder ein Endergebnis warten müssen. All dies bedeutet, dass ein On-Device-KI-Assistent potenziell mit Gesprächsgeschwindigkeit laufen, Bilder/Texte deutlich schneller generieren, Artikel schneller zusammenfassen usw. könnte. Apples Lösung bedeutet jedoch, dass Nutzer nicht unbedingt viel RAM benötigen, um die Reaktionsfähigkeit der On-Device-KI auf Aufgaben zu beschleunigen.

Apples Ansatz könnte es alten und neuen iPhones ermöglichen, synthetische KI-Funktionen direkt auf dem Gerät anzubieten. Das ist wichtig, da Apples iPhones in der Regel weniger RAM bieten als High-End-Android-Telefone. Die iPhone 11-Serie bietet beispielsweise nur 4 GB RAM, während selbst das Einstiegsmodell iPhone 15 nur 6 GB hat.

Apple ist nicht der einzige Mobilfunkanbieter, der an der Verkleinerung von LLM arbeitet. Die neuesten Flaggschiff-Chips von Qualcomm und MediaTek unterstützen beide INT4-Präzision, um diese Modelle zu verkleinern. So oder so versuchen die Unternehmen, neue Wege zu finden, um die Systemanforderungen für On-Device-KI zu senken, damit auch Low-End-Telefone diese Funktion anbieten können.

[Anzeige_2]

Quellenlink

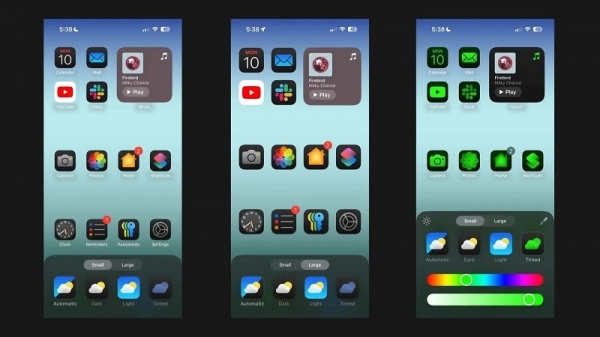

![[Foto] Generalsekretär To Lam nimmt am 80. Jahrestag des traditionellen Tages des Kultursektors teil](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/8/23/7a88e6b58502490aa153adf8f0eec2b2)

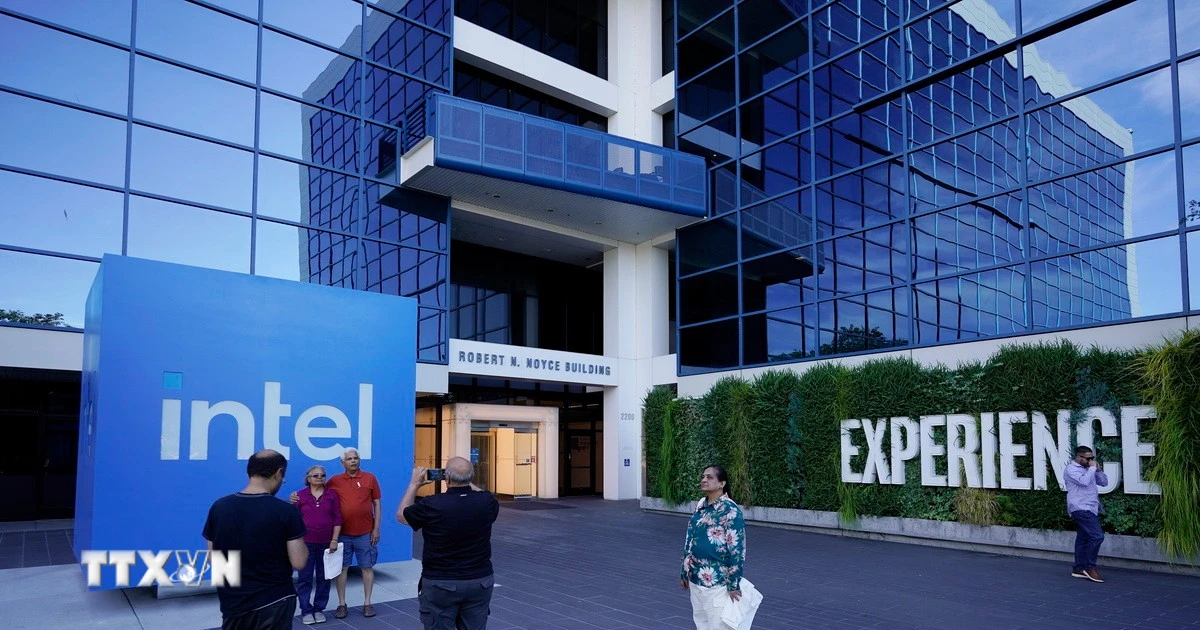

![[Foto] Premierminister Pham Minh Chinh leitet die Sitzung des Ständigen Ausschusses des Regierungsparteikomitees](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/8/23/8e94aa3d26424d1ab1528c3e4bbacc45)

Kommentar (0)