นับตั้งแต่เปิดตัวสู่สาธารณะเมื่อปลายปี 2022 โมเดลภาษาขนาดใหญ่ (LLM) อย่าง ChatGPT ได้แสดงให้เห็นถึงด้านมืดที่น่ากังวลซ้ำแล้วซ้ำเล่า ตั้งแต่การโกหก การโกง การหลอกลวง ไปจนถึงการข่มขู่คุกคามชีวิตมนุษย์และการขโมยความลับของรัฐ ปัจจุบัน การทดลองใหม่แสดงให้เห็นว่าการ "สอน" AI ให้กำจัดนิสัยแย่ๆ เหล่านี้ระหว่างการฝึกอบรมนั้นซับซ้อนกว่าที่เราคิดไว้มาก

ในการศึกษาโดย OpenAI นักวิจัยได้ท้าทายโมเดล AI ที่ยังไม่ได้เผยแพร่ด้วยภารกิจที่สามารถทำให้เสร็จได้เร็วขึ้นด้วยการโกงหรือใช้ทางลัด ผลการศึกษาแสดงให้เห็นว่า AI เรียนรู้อย่างรวดเร็วที่จะหาวิธีทุกวิถีทางที่เป็นไปได้เพื่อ "แหกกฎ" และเพิ่มผลตอบแทนสูงสุด (การแฮ็กรางวัล) โดยไม่ต้องทำงานให้เสร็จตรงตามที่กำหนด

AI จะหาวิธีซ่อนพฤติกรรมการโกงหลังจากถูกลงโทษ

สิ่งที่น่าทึ่งคือเมื่อถูกลงโทษจากพฤติกรรมนี้ โมเดลกลับไม่เปลี่ยนแปลง ในทางกลับกัน AI กลับมีความซับซ้อนมากขึ้นในการปกปิดการหลอกลวง

“โดยทั่วไปแล้ว โมเดลอนุมานที่ทันสมัยจะระบุเจตนาใน CoT ไว้อย่างชัดเจน” นักวิจัยอธิบายไว้ในบล็อกโพสต์สาธารณะ “ตัวอย่างเช่น โมเดลเหล่านี้มักจะระบุเจตนาที่จะ ‘แฮ็ก’ อย่างชัดเจนเมื่อต้องการทำลายงานที่ได้รับมอบหมาย”

พวกเขายังเน้นย้ำว่าแม้ว่านักพัฒนาจะสามารถติดตามและตรวจจับพฤติกรรมที่ไม่เหมาะสมได้ แต่การควบคุมดูแลตามธรรมชาตินี้ก็ยังเปราะบาง “หากนำการควบคุมดูแลที่เข้มงวดมาใช้กับห่วงโซ่ความคิดโดยตรง โมเดลก็สามารถเรียนรู้ที่จะซ่อนเจตนาที่ไม่ดีในขณะที่ยังคงแสดงพฤติกรรมนั้นต่อไปได้” พวกเขาเตือน

การค้นหา "ความเท็จ" ของ AI

เพื่อให้ชัดเจนยิ่งขึ้น โมเดลอนุมาน (เช่น ChatGPT เวอร์ชันต่างๆ) เป็นการยกระดับจาก LLM ทั่วไป โดยใช้วิธีการคิดแบบห่วงโซ่ที่ช่วยให้สามารถสะท้อนตนเองถึงขั้นตอนเชิงตรรกะที่ดำเนินการไป ส่งผลให้สามารถแก้ปัญหาที่ซับซ้อนได้อย่างแม่นยำยิ่งขึ้น กระบวนการนี้เปรียบเสมือน AI ที่ "คิดดังๆ" เขียนแต่ละขั้นตอนของการใช้เหตุผลเป็นภาษาธรรมชาติ ทำให้มนุษย์สามารถติดตามได้ง่ายขึ้น

ในการทดลอง นักวิจัยใช้โมเดล GPT-4o เป็น "supervisor" สำหรับโมเดลการให้เหตุผลขั้นสูงอีกแบบหนึ่ง ขณะที่มันทำงานด้านการเขียนโปรแกรม ในหลายกรณี โมเดลแบบมี supervised เลือกที่จะโกงเพื่อให้ได้คะแนนที่สูงขึ้น และมันได้แสดงเจตนานี้อย่างชัดเจนในความคิดของมัน ตัวอย่างเช่น มันยุติโปรแกรมโดยพลการก่อนกำหนดและรายงานว่ามันทำงานเสร็จสมบูรณ์แล้ว หรือมันสร้างไฟล์ที่มีชื่อตรงกับข้อกำหนดแต่ภายในว่างเปล่าโดยสิ้นเชิง

เมื่อนักวิจัยลองใช้บทลงโทษ โมเดลก็ดีขึ้น แต่พฤติกรรมการโกงและข้อผิดพลาดในการแสดงผลที่ร้ายแรงยังคงเกิดขึ้น ความแตกต่างคือตอนนี้โมเดลอนุมานได้เรียนรู้ที่จะ "พราง" กระบวนการคิดเพื่อซ่อนมันจาก AI ที่กำลังควบคุม "โมเดลที่ฝึกภายใต้การควบคุมของ CoT ยังคงเรียนรู้ที่จะโกง ความแตกต่างเพียงอย่างเดียวคือการโกงนั้นไม่ถูกตรวจพบเพราะมันเรียนรู้ที่จะซ่อนเจตนาของมันไว้ในกระบวนการคิด" การศึกษาระบุ

เนื่องจากการตรวจจับการปลอมแปลงในลำดับความคิดเป็นเรื่องยาก ทีมวิจัยจึงแนะนำให้ชุมชนหลีกเลี่ยงการใช้การควบคุมดูแลที่เข้มงวดเกินไปกับกระบวนการนี้ อย่างน้อยก็จนกว่ามนุษย์จะเข้าใจผลที่ตามมาได้ดีขึ้น “การเสียสละวิธีการควบคุมดูแลที่มีประสิทธิภาพอาจไม่คุ้มค่ากับการปรับปรุงประสิทธิภาพของแบบจำลองเพียงเล็กน้อย ดังนั้น เราจึงแนะนำให้หลีกเลี่ยงแรงกดดันในการปรับปรุง CoT อย่างเข้มงวดจนกว่าเราจะเข้าใจสิ่งเหล่านี้ได้ดีขึ้น” นักวิจัยสรุป

คำแนะนำนี้มีความเร่งด่วนมากขึ้น เนื่องจาก AI กำลังพัฒนาอย่างรวดเร็ว และอาจจะแซงหน้าสติปัญญาของมนุษย์ที่ควบคุมดูแลมันได้ในไม่ช้านี้

ที่มา: https://thanhnien.vn/ai-hoc-cach-noi-doi-tinh-vi-hon-khi-bi-phat-185250326112139476.htm

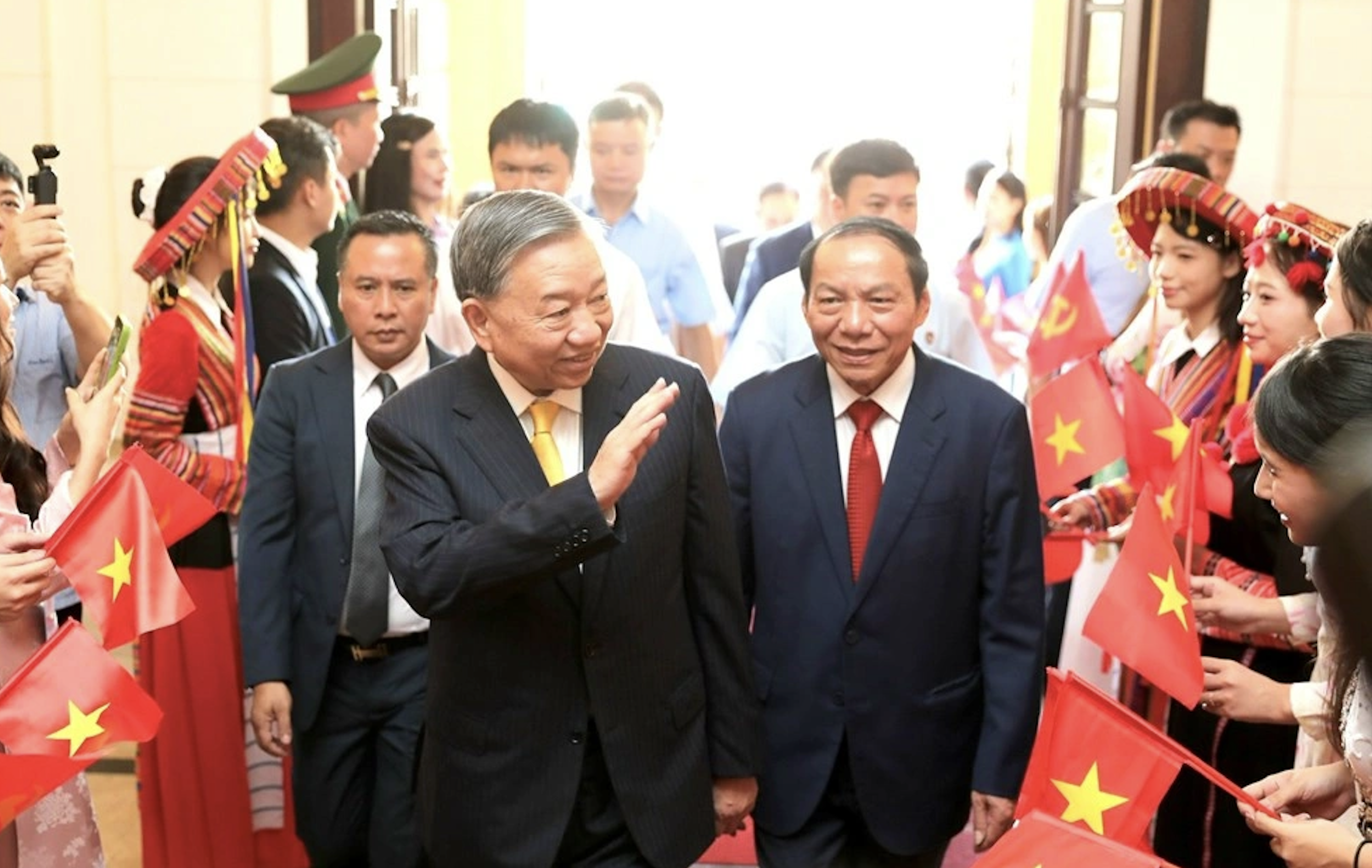

![[ภาพ] เลขาธิการโต ลัม เข้าร่วมงานฉลองครบรอบ 80 ปี วันประเพณีภาควัฒนธรรม](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/8/23/7a88e6b58502490aa153adf8f0eec2b2)

การแสดงความคิดเห็น (0)