인공지능(AI)은 OpenAI가 2022년 11월에 ChatGPT를 발표한 이후 기술 업계에서 가장 큰 화두가 되어 왔습니다. 그 후 Google, Meta, Microsoft 등의 회사도 자체 AI 개발에 막대한 투자를 했습니다.

빅테크 기업들은 AI에 대한 야망을 공개적으로 밝혀왔지만, 최근에는 이 기술이 자사 사업에 미치는 위험에 대해 조용히 언급해 왔습니다. 구글의 모회사인 알파벳은 2023년 연례 보고서에서 AI 제품과 서비스가 윤리적, 기술적, 법적, 규제적, 기타 여러 과제를 안고 있으며, 이는 자사 브랜드와 수요에 부정적인 영향을 미칠 수 있다고 밝혔습니다.

블룸버그에 따르면 메타, 마이크로소프트, 오라클 역시 미국 증권거래위원회(SEC)에 제출한 보고서에서 AI에 대한 우려를 언급했는데, 해당 보고서의 "위험 요소" 항목에 종종 언급되어 있습니다. 예를 들어, 마이크로소프트는 생성 AI 기능이 예상치 못한 보안 위협에 취약할 수 있다고 밝혔습니다.

메타(Meta)의 2023년 연례 보고서에서 페이스북 모회사는 "AI 개발 및 배포와 관련된 상당한 위험이 존재한다"며 "AI 사용이 서비스, 제품 또는 비즈니스를 개선할 것이라는 보장은 없다"고 강조했습니다. 메타는 사용자에게 해를 끼치고 소송에 노출될 수 있는 AI 시나리오를 나열했는데, 여기에는 허위 정보(선거 등), 유해 콘텐츠, 지적 재산권 침해, 데이터 프라이버시 등이 포함됩니다.

한편, 대중은 AI가 일부 직업을 쓸모없게 만들거나 사라지게 만들거나, 개인 데이터로 훈련된 대규모 언어 모델이 잘못된 정보를 퍼뜨릴 수 있다는 우려를 표명했습니다.

6월 4일, OpenAI의 전·현직 직원들이 기술 기업들에 AI의 위험을 완화하기 위한 더 많은 노력을 촉구하는 "의향서"를 보냈습니다. 이들은 AI가 불평등, 조작, 허위 정보를 심화시킬 뿐만 아니라, 통제되지 않는 자동화된 AI 시스템이 인류의 생존을 위협할 것이라고 우려하고 있습니다.

원천

![[사진] 토람 사무총장, 문화계 전통의 날 80주년 기념 행사 참석](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/8/23/7a88e6b58502490aa153adf8f0eec2b2)

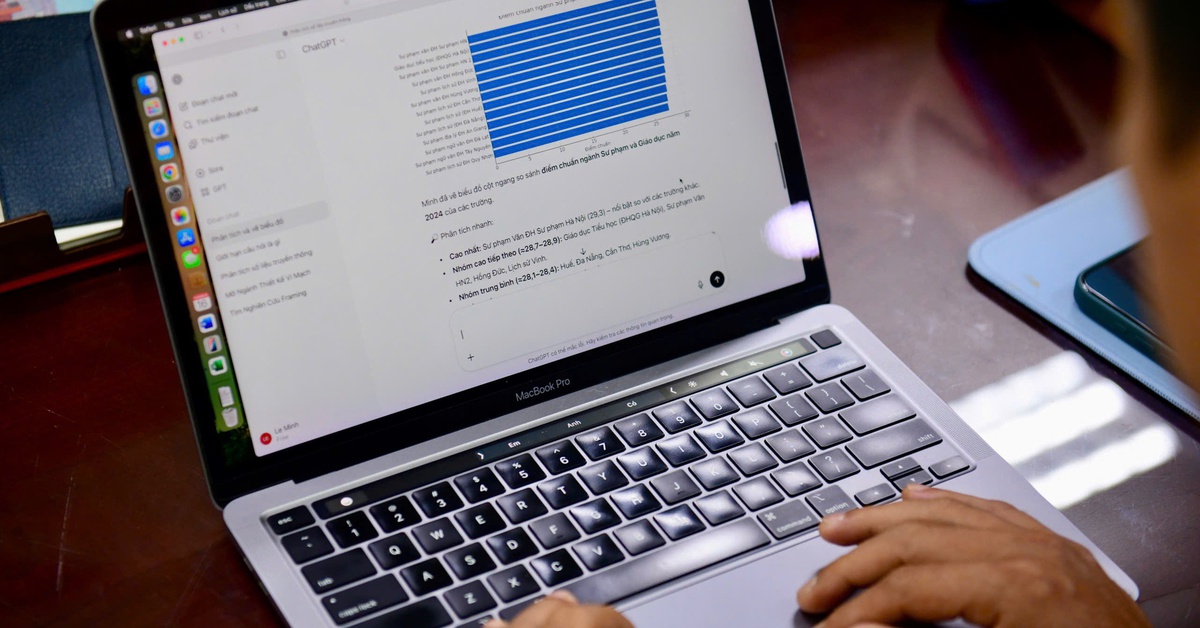

![[사진] 팜민친 총리가 정부당 상무위원회 회의를 주재하고 있다](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/8/23/8e94aa3d26424d1ab1528c3e4bbacc45)

댓글 (0)